AICで解決!過学習との戦いで勝つモデル選択術【東京情報大学・嵜山陽二郎博士のAIデータサイエンス講座】

統計モデルを構築する際、変数が多いとモデルはデータに過剰に適応してしまい(過学習)、変数が少ないとモデルは頑健だが誤差が大きくなります。このバランスを見つけることが重要です。モデルの複雑さと予測精度のバランスを評価するために赤池情報量規準(AIC)が用いられます。AICは、モデルの適合度と変数の数を考慮し、より少ない値を示すモデルが優れていると判断されます。この指標は、モデルがデータに対して適切な複雑さを持つかどうかを判断するのに役立ちます。適切なモデル選択は、予測の精度を保ちながらも過学習を避けるために不可欠です。

![]() ▼▼▼▼▼▼▼▼

▼▼▼▼▼▼▼▼

チャンネル登録はこちら

統計モデルの複雑性

回帰分析では、重回帰分析の方が、直線回帰分析よりも最小2乗法で残差平方和が小さくなるので、より予測精度の高い、優れた分析手法ではないか、と思われるかもしれません。

変数を多くした方が、確かに観測値へのあてはまりがよいので、より良いモデルであると一見思います。

しかし、果たして本当にそうでしょうか。

上の図は、アルドステロンという体の水分量の調節に関与するホルモンの変動をあらわしたものです。

血中アルドステロン濃度は早朝に高くなり深夜に低くなるので、このような周期的な日内変動をします。

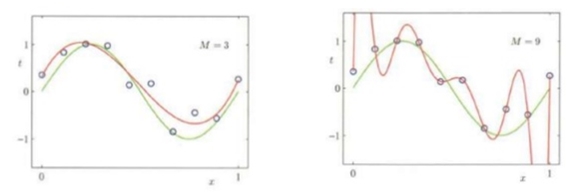

さて、左はこの変動を3変数の重回帰モデルにあてはめた結果で、右は9変数の重回帰モデルにあてはめた結果です。どちらの方が良いでしょうか。

モデルの観測値へのあてはまりについては確かに3変数モデルより9変数モデルのほうが良いですが、9変数というのはあまりに変数が多すぎないでしょうか。

この場合総合的に考えると、左の方が妥当な推定といえます。

右は確かに観測値に忠実に複雑な推定をしていますが、果たしてアルドステロンがこのように変動するという医学的根拠はどこにあるのでしょうか。

また、偶々この患者さんの観測値で予測ができたものの、別の患者さんの観測値で同じモデルを使用したら、同じような予測は果たしてできるでしょうか。

逆に言えば、3変数のモデルの方が、より多くの観測値のパターンにあてはめることができる、といえるわけです。

このようなモデルを頑健(ロバスト)なモデルといいます。

一方、モデルが頑健であればあるほど、観測値と予測値の差(誤差)は大きくなります。

直線回帰分析が良い例です。

あまり頑健すぎても予測の精度は劣化してしまいます。

変数は多すぎても少なすぎてもいけません。

では、どの程度の按配のモデルが適切なモデルなのでしょうか。

赤池情報量規準(AIC)

これについては、過去に多くの統計学者が数多くの説を提唱してきましたが、最も多く使われている基準として、日本の誇る数理統計学者、赤池弘次先生の提唱した赤池情報量規準(AIC)があります。

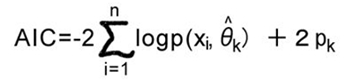

式の意味の詳細は割愛しますが、最初の項がデータのあてはまりのよさを表す項、第2項が変数の数をあらわす項です。

赤池情報量規準(AIC)は小さい方がよく、あてはまりがよくかつ変数が少ないモデルが良いモデルということになります。

モデルは複雑でない頑健なモデルの方が良いですが、あてはまりのよさも重要です。

モデルの良さの指標としては赤池情報量規準(AIC)があります。

ChatGPTに聞いてみた

プロンプト

あなたは最高のデータサイエンティストです。

赤池情報量規準、AICについて解説してください。

#制約条件:

サルでもわかる平易な日本語で

文字数は300字程度

ChatGPTの回答

赤池情報量規準、通称AICは、統計モデルを選ぶときにめちゃくちゃ役立つ数字です。モデルって、データを説明するための数学的な式のこと。でも、モデルがたくさんあると、どれを使えばいいか迷いますよね。そこでAICの出番です。AICは、モデルがデータをどれくらいうまく説明しているかと、モデルの複雑さ(使っている説明変数の数)のバランスを見ます。要は、シンプルだけどデータをちゃんと説明できているモデルが良いモデル、ってこと。AICの数値が小さいモデルほど、そのバランスが良く取れていると言えます。例えば、天気予報で気温だけじゃなくて、湿度や風速も考えたくなるかもしれません。でも、全部入れるとモデルが複雑になりすぎる。AICを使うと、ちょうど良いバランスのモデルを選べるんです。簡単に言うと、AICは「シンプルだけどデータをしっかり説明できるモデル選びのお手伝いをする数字」です。これによって、たくさんあるモデルの中から、一番いいバランスのものを選ぶことができるんです。